Page 49 - My FlipBook

P. 49

Brochure 2020

為 了 有 效 運 用 電 腦 視 覺 技 術 偵 測 車 輛、 停 等 車 列 及 計 能力。這一項改變能夠適用於現行的所有主流 CNN 架構,

包含 ResNet、ResNeXt、DenseNet 等,並能在減少各種

算 車 速 等 參 數, 我 們 團 隊 決 定 設 計 新 的 機 器 學 習 模 型 CNN 10% 到 30% 的運算量的條件下仍維持或提升 image

來 加 速 處 理 視 訊 框 架 (frame) 的 速 度 及 保 持 甚 至 增 加 classi cation 的正確率。且由於 CSPNet 設計時考慮到運

計 算 或 偵 測 的 準 確 率。 我 們 團 隊 提 出 了 Cross Stage

Partial Network(CSPNet) 的 新 模 型。CSPNet 利 用 優 化 算成本、記憶體頻寬、負載平衡…,一般而言能夠減少

Convolutional Neural Network (CNN) 架構中倒傳遞梯度流 40% 到 80% 的記憶體頻寬需求,因此更適用於資源受限

資訊傳導路徑的策略,最大化各層權重求取出的特徵差 的邊緣運算平台。

異性,使得 CNN 在輕量化過程中仍能維持高水準的學習

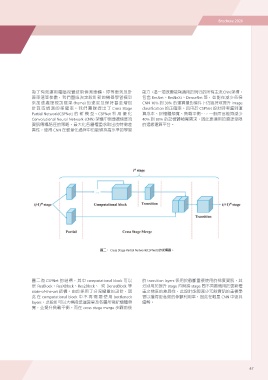

圖二: Cross Stage Partial Network(CSPNet) 的架構圖。

圖 二 為 CSPNet 的 結 構, 其 中 computational block 可 以 的 transition layers 係用於截斷重複使用的梯度資訊,其

是 ResBlock、ResXBlock、Res2Block、 或 DenseBlock 等 分別用於提升 stage 內與跨 stage 間不同區塊用於更新權

state-of-the-art 結構。由於採用了分流權重的設計,因

此 在 computational block 中 不 再 需 要 使 用 bottleneck 重之梯度的差異性,此設計能夠減少冗餘資訊的重複學

layers,此設計可以大幅降低運算量及各層所需記憶體頻 習以獲得更高效的參數利用率,因此在輕量 CNN 中更具

寬,並提升負載平衡。而在 cross stage merge 步驟前後 優勢。

47

為 了 有 效 運 用 電 腦 視 覺 技 術 偵 測 車 輛、 停 等 車 列 及 計 能力。這一項改變能夠適用於現行的所有主流 CNN 架構,

包含 ResNet、ResNeXt、DenseNet 等,並能在減少各種

算 車 速 等 參 數, 我 們 團 隊 決 定 設 計 新 的 機 器 學 習 模 型 CNN 10% 到 30% 的運算量的條件下仍維持或提升 image

來 加 速 處 理 視 訊 框 架 (frame) 的 速 度 及 保 持 甚 至 增 加 classi cation 的正確率。且由於 CSPNet 設計時考慮到運

計 算 或 偵 測 的 準 確 率。 我 們 團 隊 提 出 了 Cross Stage

Partial Network(CSPNet) 的 新 模 型。CSPNet 利 用 優 化 算成本、記憶體頻寬、負載平衡…,一般而言能夠減少

Convolutional Neural Network (CNN) 架構中倒傳遞梯度流 40% 到 80% 的記憶體頻寬需求,因此更適用於資源受限

資訊傳導路徑的策略,最大化各層權重求取出的特徵差 的邊緣運算平台。

異性,使得 CNN 在輕量化過程中仍能維持高水準的學習

圖二: Cross Stage Partial Network(CSPNet) 的架構圖。

圖 二 為 CSPNet 的 結 構, 其 中 computational block 可 以 的 transition layers 係用於截斷重複使用的梯度資訊,其

是 ResBlock、ResXBlock、Res2Block、 或 DenseBlock 等 分別用於提升 stage 內與跨 stage 間不同區塊用於更新權

state-of-the-art 結構。由於採用了分流權重的設計,因

此 在 computational block 中 不 再 需 要 使 用 bottleneck 重之梯度的差異性,此設計能夠減少冗餘資訊的重複學

layers,此設計可以大幅降低運算量及各層所需記憶體頻 習以獲得更高效的參數利用率,因此在輕量 CNN 中更具

寬,並提升負載平衡。而在 cross stage merge 步驟前後 優勢。

47